Ang Nvidia Eye Contact ay Nakakatakot at Nakakatuwa

Noong nakaraang linggo, naglunsad ang Nvidia ng bagong bersyon ng Nvidia Broadcast (nagbubukas sa bagong tab) — ang malalim na pag-aaral at software na pinapagana ng AI na maaaring gumawa ng pagpigil sa ingay, pag-alis/pagpapalit ng background, pag-frame ng camera, at ngayon… Eye Contact. Kasalukuyang nasa beta ang huling iyon, marahil sa magandang dahilan, at makikita mo kung ano ang hitsura nito na “live” sa pansubok na video sa itaas.

Ang AI at malalim na pag-aaral ay madalas na nasa balita kamakailan, para sa magandang dahilan. Ang mga bagay tulad ng Dall-E, Midjourney, at Stable Diffusion ay lumilikha ng sining mula sa teksto, kadalasang may kapansin-pansing mga resulta. At sa ibang pagkakataon, napupunta ka sa mga nilalang na mutant na gusot at ang dalawahang ulo, problema sa maraming paa. Sa panig ng teksto, ang ChatGPT ay maaaring tunog ng kamatayan para sa mga sanaysay at pamamahayag sa Ingles — at hindi, hindi nito isinulat ang post ng balitang ito.

Ang ideya sa likod ng Eye Contact ay sapat na simple upang ipahayag: Kapag ikaw ay nasa isang webcast o pulong, kadalasan ay umiiwas ka ng tingin sa camera. Sa katunayan, may isang tunay na pagkakataon na halos palagi kang nakatingin sa malayo sa camera dahil nakaupo ito sa tuktok ng screen, habang ang mga bagay na gusto mong tingnan ay nasa screen talaga. Paano kung sanayin mo ang isang modelo ng AI sa mga mukha at turuan itong iwasto ang mga larawan kung saan ang isang tao ay hindi nakatingin nang diretso sa lens? Kumuha ng milyun-milyong larawan na naaangkop na naka-tag, i-feed ito sa network, at maglalabas ng isang kamangha-manghang tool, tama ba?

Malinaw na hindi ito ganoon kasimple, dahil pinag-uusapan ng Nvidia ang tungkol sa feature na Eye Contact nito sa loob ng mahigit isang taon, ngunit ngayon pa lang ito napupunta sa public release. Ang mga pagkakaiba sa pagitan ng lahat ng napakaraming mukha sa buong mundo ay ginagawa itong isang mahirap na problema na “lutasin,” at kahit ngayon ang mga resulta ay hindi perpekto, kung inilalagay natin ito nang maayos.

Ang isa sa mga bagay na napansin ko sa pagsubok ay madalas na umiikot ang live na video feed sa pagitan ng pagtingin ko sa camera at sa pagtingin ko sa ibang lugar, kahit na ang aking focus ay karaniwang nasa parehong lugar. Hindi ako sigurado kung sinadya ba iyon — ang pagkakaroon ng isang taong nakatitig nang direkta sa camera sa buong video chat ay magsisimulang maging katakut-takot — ngunit kung mayroong ilang timing na kasangkot, dapat itong ayusin.

Ano ang mas mahirap sabihin ay kung ang ganitong uri ng epekto ay kahit na kapaki-pakinabang sa kabuuan. Kung gusto mong magmukhang may eye contact ka sa camera, hindi ba dapat matuto kang tumingin sa lens ng camera? Ang paglutas ng pagkakamali ng tao sa pamamagitan ng AI ay maaaring lumikha lamang ng palpak na gawi, at pagkatapos ay ano ang mangyayari kung mapunta ka sa isang camera na hindi nag-autocorrect sa iyong feed?

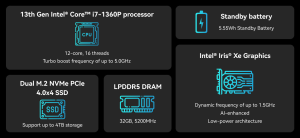

Ngunit gusto mo man o hindi, ang Nvidia Broadcast na may Eye Contact ay magagamit na ngayon para sa mga may-ari ng RTX kahit saan upang subukan. Ang aking pagsubok ay ginawa gamit ang isang RTX 3090 Ti, ngunit sa ngayon ang mga kinakailangan ng system ay naglilista pa rin ng isang RTX 2060 bilang ang entry point, at kasama na rin ang mga mobile RTX 3050 GPU, hangga’t naiintindihan ko ang mga bagay (bagaman wala akong access sa isa sa mga iyon).

Pangmatagalan, pinaghihinalaan ko na sa isang punto ay matatapos ang Nvidia sa ilang partikular na modelo ng AI na mas kumplikado at nangangailangan ng mas mabilis na hardware kaysa sa isang RTX 2060, tulad ng tampok na Frame Generation ng DLSS 3 na nangangailangan ng isang RTX 40-series na graphics card, ngunit sa ngayon anumang Sapat na ang RTX GPU na ginawa sa nakalipas na apat na taon.

Gusto mo ba ang epekto, kinasusuklaman mo, nakakatakot, o iba pa? Ipaalam sa amin sa mga komento, kasama ang iba pang mga epekto na mas gusto mong makita. Inaasahan ko ang oras na lahat tayo ay maaaring magkaroon ng mga virtual na cartoon avatar tulad ng Toy Jensen na nagsasalita sa halip na mga totoong tao, marahil ay nagbabasa ng mga artikulo na isinulat ng AI, na ang mga video at artikulo ay parehong ginagamit ng AI. Ito ay mga bot mula doon.