Nanunukso ang Bagong Pananaliksik sa Memorya ng 100x Density Jump, Pinagsamang Compute at Memory

Ang bagong pananaliksik sa kahabaan ng mga hangganan ng engineering ng mga materyales ay nangangako para sa isang tunay na kahanga-hangang pagpapabuti ng pagganap para sa mga computing device. Isang pangkat ng pananaliksik na pinamunuan ni Markus Hellbrand et al. at nauugnay sa Unibersidad ng Cambridge ay naniniwala na ang bagong materyal, batay sa mga layer ng hafnium oxide na na-tunnel ng mga spike ng barium na nagbabago ng boltahe, ay nagsasama ng mga katangian ng memorya at mga materyales na nakagapos sa pagproseso. Nangangahulugan iyon na maaaring gumana ang mga device para sa pag-iimbak ng data, na nag-aalok saanman mula 10 hanggang 100 beses ang density ng mga kasalukuyang medium ng imbakan, o maaari itong magamit bilang isang yunit ng pagpoproseso.

Na-publish sa Science Advances journal, ang pananaliksik ay nagbibigay sa amin ng isang daan kung saan maaari kaming magtapos nang may mas malaking density, performance at kahusayan sa enerhiya sa aming mga computing device. Sa totoo lang, ang isang tipikal na USB stick na batay sa teknolohiya (na tinatawag na tuloy-tuloy na hanay) ay maaaring magkaroon ng 10 at 100 beses na higit pang impormasyon kaysa sa kasalukuyang ginagamit namin.

Sa pagdodoble ng RAM sa densidad tuwing apat na taon, gaya ng itinuro ng JEDEC, aabutin ng mga gumagawa ng RAM ng ilang dekada upang tuluyang makamit ang parehong antas ng density tulad ng ipinakita ng teknolohiyang ito ngayon.

Ang device ay isa ring ilaw sa tunnel ng neuromorphic computing. Tulad ng mga neuron sa ating utak, ang materyal (kilala bilang isang resistive switching memory) ay may pangakong magtrabaho bilang parehong storage at processing medium. Iyan ay isang bagay na hindi nangyayari sa aming kasalukuyang teknolohiya ng semiconductor: ang transistor at mga kaayusan sa disenyo ng mga materyales ay ibang-iba sa pagitan ng kung ano ang kailangan mo para sa isang memory cell at kung ano ang kailangan mo para sa isang pagproseso (pangunahin sa mga tuntunin ng pagtitiis, tulad ng sa, ang kakayahang hindi makaranas ng mga degradasyon ng pagganap) na sa kasalukuyan ay walang paraan upang pagsamahin ang mga ito.

Ang kawalan ng kakayahang pagsamahin ang mga ito ay nangangahulugan na ang impormasyon ay dapat na patuloy na dumadaloy sa pagitan ng sistema ng pagpoproseso at ng iba’t ibang mga cache nito (kapag nag-iisip ng isang modernong CPU), pati na rin ang panlabas na memory pool nito (sa pagtingin sa iyo, pinakamahusay na mga DDR5 kit sa merkado). sa computing, ito ay kilala bilang von Neumann’s bottleneck, ibig sabihin, ang isang system na may hiwalay na memorya at mga kakayahan sa pagpoproseso ay lilimitahan ng bandwidth sa pagitan nilang dalawa (kung ano ang karaniwang kilala bilang bus). Ito ang dahilan kung bakit ang lahat ng kumpanya ng disenyo ng semiconductor (mula sa Intel hanggang AMD, Nvidia, at marami pang iba) ay nagdidisenyo ng dedikadong hardware na nagpapabilis sa pagpapalitan ng impormasyong ito, gaya ng Infinity Fabric at NVLink.

Ang problema ay ang pagpapalitan ng impormasyon na ito ay may halaga ng enerhiya, at ang halaga ng enerhiya na ito ay kasalukuyang nililimitahan ang itaas na mga hangganan ng matamo na pagganap. Tandaan na kapag umiikot ang enerhiya, mayroon ding mga likas na pagkalugi, na nagreresulta sa pagtaas ng konsumo ng kuryente (kasalukuyang mahirap na limitasyon sa aming mga disenyo ng hardware at lumalaking priyoridad sa disenyo ng semiconductor) pati na rin ang init — isa pang mahirap na limitasyon na humantong sa pagbuo ng lalong kakaibang mga solusyon sa pagpapalamig upang subukan at pahintulutan ang batas ni Moore na humina nang ilang sandali pa. Siyempre, mayroon ding sustainability factor: inaasahan na ang pag-compute ay kumonsumo ng hanggang 30% ng pandaigdigang pangangailangan ng enerhiya sa hindi gaanong kalayuan sa hinaharap.

“Sa isang malaking lawak, ang pagsabog na ito sa mga pangangailangan ng enerhiya ay dahil sa mga pagkukulang ng kasalukuyang mga teknolohiya sa memorya ng computer,” sabi ng unang may-akda na si Dr. Markus Hellenbrand, mula sa Cambridge’s Department of Materials Science and Metallurgy. “Sa maginoo na computing, mayroong memorya sa isang panig at pinoproseso sa kabilang panig, at ang data ay binabasa pabalik sa pagitan ng dalawa, na nangangailangan ng parehong enerhiya at oras.”

Ang mga benepisyo ng pagsasama-sama ng memorya at pagproseso ay medyo kahanga-hanga, gaya ng maiisip mo. Habang ang kumbensyonal na memorya ay may kakayahang dalawang estado lamang (isa o zero, ang dahilan para sa “binary” na katawagan), maaaring baguhin ng resistive switching memory device ang resistensya nito sa pamamagitan ng isang hanay ng mga estado. Ito ay nagbibigay-daan dito upang gumana sa mas mataas na mga uri ng mga boltahe, na kung saan ay nagbibigay-daan para sa karagdagang impormasyon na ma-encode. Sa isang sapat na mataas na antas, ito ay halos parehong proseso na nangyayari sa NAND realm, na may mga pagtaas sa mga bit bawat cell na tumutugma sa mas mataas na bilang ng mga posibleng estado ng boltahe na naka-unlock sa disenyo ng memory cell.

Ang isang paraan upang maiba ang pagpoproseso mula sa pag-iimbak ay ang pagsasabi na ang pagpoproseso ay nangangahulugan na ang impormasyon ay sumasailalim sa mga writes at rewrites (mga pagdaragdag o pagbabawas, pagbabagong-anyo o muling pag-aayos) nang kasing bilis ng paghiling nito sa paglipat ng cycle. Ang pag-iimbak ay nangangahulugan na ang impormasyon ay kailangang maging static sa mas mahabang panahon — marahil dahil ito ay bahagi ng Windows o Linux kernels, halimbawa.

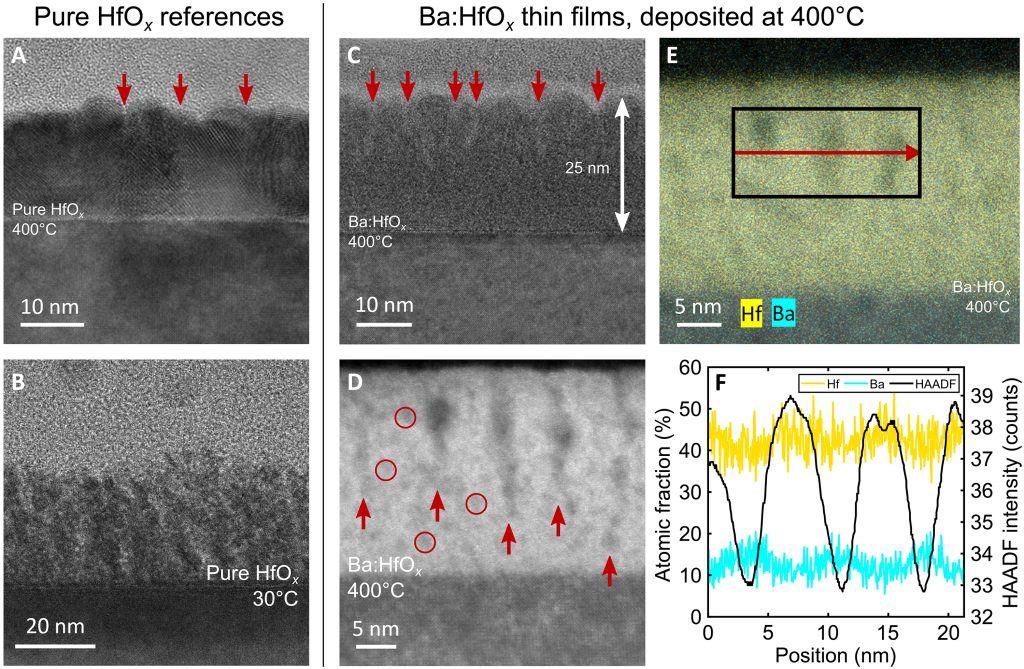

Upang mabuo ang mga aparatong ito ng synapse, tulad ng tinutukoy ng papel sa kanila, ang pangkat ng pananaliksik ay kailangang humanap ng paraan upang harapin ang isang bottleneck sa engineering ng mga materyales na kilala bilang problema sa pagkakapareho. Dahil ang hafnium oxide (HfO2) ay hindi nagtataglay ng anumang istraktura sa atomic level, ang hafnium at oxygen atoms na maaaring gumawa o masira ang mga insulating properties nito ay idineposito nang basta-basta. Nililimitahan nito ang aplikasyon nito para sa pagsasagawa ng mga electron (electrical power); mas maayos ang atomic na istraktura, ang hindi bababa sa paglaban ay dulot, kaya mas mataas ang bilis at kahusayan. Ngunit nalaman ng koponan na ang pagdeposito ng barium (Ba) sa loob ng manipis na mga pelikula ng hindi nakaayos na hafnium oxide ay nagresulta sa napaka-order na mga tulay ng barium (o mga spike). At dahil ang kanilang mga atomo ay mas nakabalangkas, ang mga tulay na ito ay maaaring mas mahusay na payagan ang daloy ng mga electron.

Nakuha gamit ang Transmission Electron Microscopy (TEM), ang mga larawan ay nagpapakita ng tumaas na pagkakasunud-sunod sa pagdeposito ng hafnium oxide (gugulo at natural na deposition, tulad ng sa larawan A) kapag ini-tunnel ng mga dynamic na nababagong Barium spike. (Kredito ng larawan: Cambridge University/Markus Hellbrand et al.)

Ngunit nagsimula ang saya nang makita ng research team na maaari nilang dynamic na baguhin ang taas ng barium spike, na nagbibigay-daan para sa pinong kontrol ng kanilang electrical conductivity. Natagpuan nila na ang mga spike ay maaaring mag-alok ng mga kakayahan sa paglipat sa isang rate ng ~20ns, ibig sabihin ay maaari nilang baguhin ang kanilang boltahe na estado (at sa gayon ay may hawak na iba’t ibang impormasyon) sa loob ng window na iyon. Natagpuan nila ang paglipat ng mga pagtitiis ng >10^4 na mga cycle, na may memory window>10. Nangangahulugan ito na habang ang materyal ay mabilis, ang maximum na bilang ng mga pagbabago sa estado ng boltahe na maaari nitong mapaglabanan ay nasa humigit-kumulang 10,000 na mga cycle – hindi isang kakila-kilabot na resulta, ngunit hindi isang kamangha-manghang resulta.

Katumbas ito ng tibay na magagamit sa teknolohiya ng MLC (Multi-Level Cell), na natural na maglilimita sa paggamit nito – ang paggamit ng materyal na ito bilang isang medium sa pagpoproseso (kung saan ang mga estado ng boltahe ay mabilis na nagbabago upang mapanatili ang isang tindahan ng mga kalkulasyon at ang kanilang mga intermediate na resulta).

Ang paggawa ng ilang rough napkin math, ang ~20 ns switching ay humahantong sa operating frequency na 50 MHz (pagko-convert sa mga cycle bawat nanosecond). Sa buong bilis ng pagpoproseso ng system ng iba’t ibang estado (gumagawa bilang GPU o CPU, halimbawa), ang ibig sabihin nito ay hihinto sa paggana ang mga tulay ng barium (maabot ang kanilang limitasyon sa pagtitiis) sa humigit-kumulang 0,002-segundo na marka (tandaan, ito ay gumagana lamang sa 50 MHz). Iyon ay mukhang hindi sapat na gumaganap para sa isang processing unit.

Ngunit para sa imbakan? Kaya, doon pumapasok ang USB stick na “10 hanggang 100 beses na mas siksik” sa mga tuntunin ng kapasidad ng memorya. Ang mga synapse device na ito ay maaaring mag-access ng mas maraming intermediate na estado ng boltahe kaysa sa kahit na ang pinakasiksik na teknolohiya ng NAND sa pinakamalawak na USB sticks ngayon – sa kadahilanan na 10 o 100.

Sino ang hindi magugustuhan na magkaroon ng 10 TeraByte o kahit 100 TeraByte na “USB 7” na nakadikit sa kanilang mga kamay?

Mayroong ilang mga gawain na dapat gawin sa mga tuntunin ng pagtitiis at bilis ng paglipat ng mga tulay ng barium, ngunit tila ang disenyo ay isang nakakaakit na patunay ng konsepto. Mas mabuti pa, gumagana na ang industriya ng semiconductor sa hafnium oxide, kaya mas kaunti ang mga bangungot sa tooling at logistik na dapat labanan.

Ngunit narito ang isang partikular na mapanlikhang posibilidad ng produkto: isipin na ang teknolohiya ay bumubuti hanggang sa punto na ito ay gawa-gawa at magagamit upang magdisenyo ng AMD o Nvidia GPU (na sa mga araw na ito ay tumatakbo sa paligid ng 2 GHz na marka). Mayroong isang mundo kung saan ang graphics card na iyon ay may kasamang reset factory state kung saan ito ay ganap na gumagana bilang memory (ngayon isipin ang isang graphics card na may 10 TB nito, kapareho ng aming hypothetical USB stick).

Isipin ang isang mundo kung saan ang inaalok ng AMD at Nvidia ay mahalagang mga programmable GPU, na may tuloy-tuloy na range-based na GPU na namamatay na nakasalansan sa mga tuntunin ng maximum na kakayahan sa storage (tandaan ang 10 hanggang 100 na mas siksik kaysa sa kasalukuyang USB). Kung ikaw ay isang AI aficionado na sumusubok na bumuo ng iyong sariling Large Language Model (LLM), maaari mong i-program ang iyong GPU upang ang tamang dami ng mga synthetic na device na ito, ang mga neuromorphic transistors na ito, ay nagpapatakbo ng mga function sa pagpoproseso — walang sinasabi kung ilang trilyong parameter na mga modelo ang mapupunta sa kalaunan habang tumataas ang kanilang pagiging kumplikado, kaya mas magiging mahalaga ang memorya.

Ang kakayahang magdikta kung ang mga transistor sa iyong graphics card ay ginagamit nang eksakto bilang memorya o eksakto tulad ng mga eye-candy-amplifier upang gawing labing-isa ang mga setting ng graphics, iyon ay ganap na nakasalalay sa end-user; mula sa kaswal na gamer hanggang sa High Performance Computing (HPC) installer. Kahit na nangangahulugan iyon ng nasusukat na pagkabulok sa kahabaan ng buhay ng mga bahagi ng ating chip.

Lagi nating ina-upgrade ang mga ito, hindi ba?

Ngunit huwag nating unahan ang ating sarili. Kahit na hindi ito kasing delikadong isyu gaya ng pagpapaunlad ng AI at regulasyon nito, kakaunti lang ang makukuha sa pangangarap sa hinaharap. Tulad ng lahat ng teknolohiya, darating ito – kapag handa na ito. kung sakali man.